딥러닝_전이학습, 순환신경망(RNN), 생성적 적대 신경망(GAN)

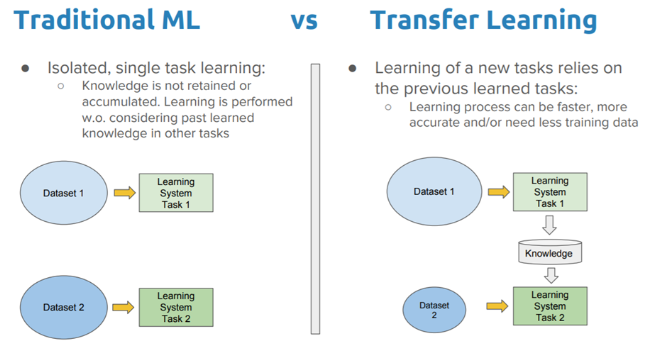

1. 전이학습(Transfer Learning)

· 과거에 문제를 해결하면서 축적된 경험(유명한 네트워크들과 같이 미리 학습시킨 모델을 가져오는 등)을 토대로 유사한 문제를 해결하도록 신경망을 학습시키는 방법

· 학습 속도가 빠르고(빠른 수렴), 상대적으로 적은 데이터셋으로 좋은 결과를 낼 수 있음

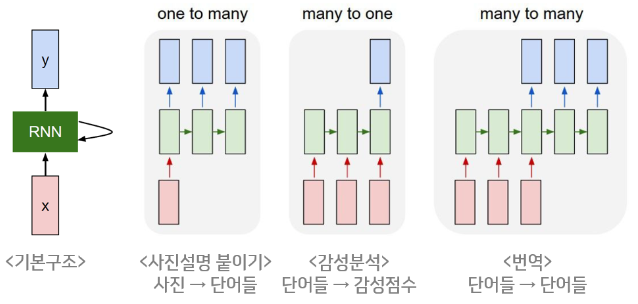

2. 순환 신경망(RNN, Recurrent Neural Networks)

· 은닉층이 순차적으로 연결되어 순환구조를 이루는 인공신경망의 한 종류로 음성, 문자 등 순차적으로 등장하는 데이터 처리에 적합한 모델이다.

· 길이에 관계없이 입/출력을 받아들일 수 있는 구조로, 다양하고 유연하게 구조를 만들수 있다.

· 주식이나 암호화폐의 시세를 예측하거나, 사람과 대화하는 챗봇 등의 모델을 만들 수 있다.

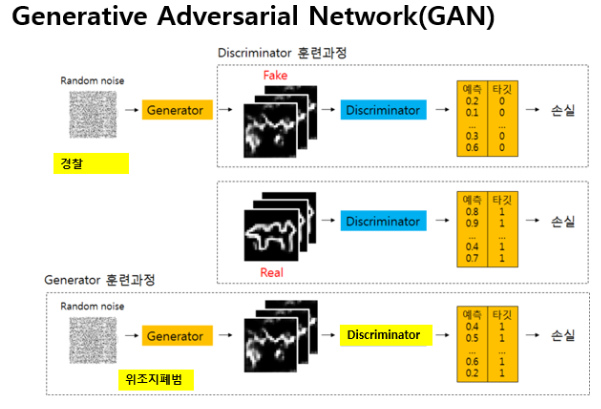

3. 생성적 적대 신경망(GAN, Generative Adversarial Network)

· 서로 적대(Adversarial)하는 관계의 2가지 모델(생성 모델과 판별 모델)을 동시에 사용하는 기술.

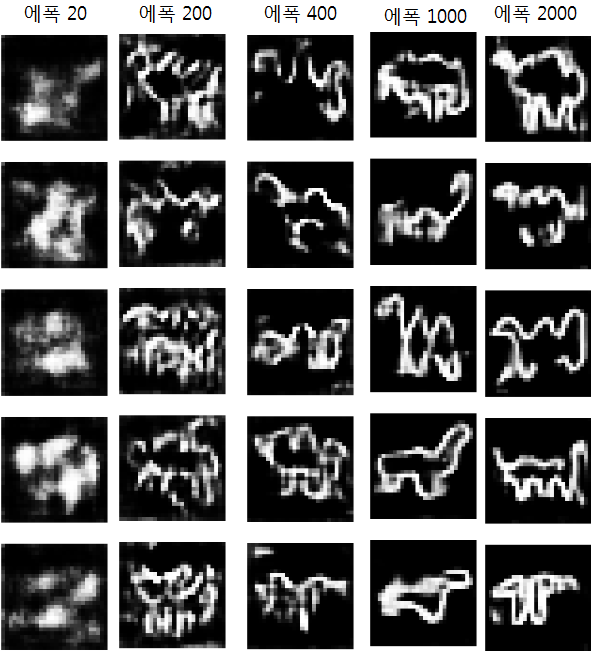

· 이 2가지의 모델의 경쟁을 통해 학습하면서 실제와 가까운 결과물을 생성한다. 생성모델(Fake)은 에폭이 지날때마다 더욱 실물과 유사해지며, 이에 따른 판별모델도 손실을 줄여나가며 정교해진다.

반응형

'DataScience > 머신러닝' 카테고리의 다른 글

| 머신러닝 :: 딥러닝 MNIST 실습_과일 종류 예측 (0) | 2022.10.14 |

|---|---|

| 머신러닝 :: 딥러닝 MNIST 실습_캐글 Sign Language 데이터셋(2)_CNN을 이용한 풀이 (0) | 2022.10.14 |

| 머신러닝 :: 합성곱 신경망(CNN, Convolutional Neural Networks) (0) | 2022.10.13 |

| 머신러닝 :: 딥러닝 MNIST 실습_캐글 Sign Language 데이터셋 (0) | 2022.10.13 |

| 머신러닝 :: 딥러닝 XOR 예측 실습(이진 논리회귀, MLP, keras functional API) (0) | 2022.10.13 |

댓글